機器學習與分析 PaaS服務 加入 SDX 共享數據體驗

行業分析師認為大數據分析雲端服務的散亂已成為企業日益嚴重的問題。不同團隊選擇差異甚大的雲端服務已逐漸成為『影子IT』,其對企業 IT 和組織架構將帶來挑戰,因為不同的模式和不一致的技術通常導致其應用範圍過於狹窄,無法協助企業內部擴展管理。此外,因為不易管控的非必要數據複製與執行也會增加成本、工作量等挑戰。

根據IDC MarketScape 發布的《2017年亞太區大數據與資料分析平台供應商分析報告》指出:「自 2017年起,IT 購買者(包括考慮投資大數據和資料分析,以及認知運算的各個企業業務線)不僅需考慮個別業務部門對平台的單一用途。而大數據分析(BDA)投資報酬率相對穩定且易於部署,各業務部門都能夠採用大數據分析解決方案,並快速地應用於不同環境。企業皆將面臨的挑戰是要如何將這些成功案例擴展或複製到更多的團隊中。」

過去一些比較為人熟悉的數據分析服務平台未能解決現有的業務需求,主要因為它們僅能支援單一用途的工作,未能與其他雲端數據服務融合。通常數據需要手動從一項服務裝置移轉到另一項服務裝置上,並儲存成新的格式,重新制定使用模式,同時也需承擔巨大的人力資源及風險。若欲整合不同的數據分析服務,其需支付昂貴的開發費用,且最終仍可能要面對效能不佳、使用者體驗不一致、資訊安全與IT管控等問題。

一個機器學習與分析平台即服務(PaaS)的雲端平台,以數據目錄共享為基礎,提供數據相關業務所需的資料。最近雲計算優化的機器學習及分析平台供應商 Cloudera 就推出具備共享數據體驗(SDX)的女 Cloudera Altus ,能支援企業不同高價值的商業用途。

SDX 允許多項數據分析功能同時執行,將不同來源的數據統一至單一群組裏。Altus 可應用於回答消費者較複雜的問題,例如最佳產品推薦,以及執行物聯網(IoT)預測性維護和進階威脅偵測。

以上資訊由www.hkitblog.com提供

深度學習+人臉辨識:將成未來安全標準!

AI 人工智能其實大家都聽了很多年,但礙於以往先天條件不足,例如硬件配置不足夠推動 AI 運算;機器深度學習的 Sample 不足;大數據分析能力欠佳等,因此一直以來都只停留在科研層面,不過近年來很多雲端服務例如是 Azure、Google 等,她們都將收集多年來的 Sample 以 Pay As You Go 的方式為開發者提供,此舉不但解決了深度學習所需要的 Sample 問題,同時亦可將 AI 的運行環境要求降低。

又 AI 又機器學習又深度學習?

AI 與機器學習、深度學習關係密不可分。機器學習通過演算法來分析資料並進行學習,最後作出相關的決定;而在這過程之中,它需要大量的資料以及演算法以完成學習的過程,愈準確的結果便需要愈大量的 Sample 讓它進行學習及演算。在早期的機器學習技術之中,它只可在有限的預先定義範圍內行動,沒有自我意識以及智慧,因此背後採用機器學習的人工智能我們會稱之為 Weak AI。現時 iPhone Siri 以及人臉辨識等,都是 Weak AI 的例子。

Weak AI 應用:AI 防火牆

很明顯,Weak AI 未必適合應用在廣泛的資安防禦問題上,事關 Weak AI 本身只可在預先定義的範圍內行動!儘管如此,採用 Weak AI 卻已可用來針對資安防禦之中狹窄的範圍,例如判斷網絡設備之中的 In/Out 流量是否可疑、判斷風險高低並自行定立規則等,從而成為一款 AI Managed Firewall 產品。

另一個 Weak AI 的例子就是人臉辨識。現今人臉辨識已可通過機器學習後懂得準確地區分出人類的性別、年紀、心情、動作以及特定的 Object,例如我們可通過臉孔作為安全登入或進出大廈的憑證。

深度學習最強 AI?

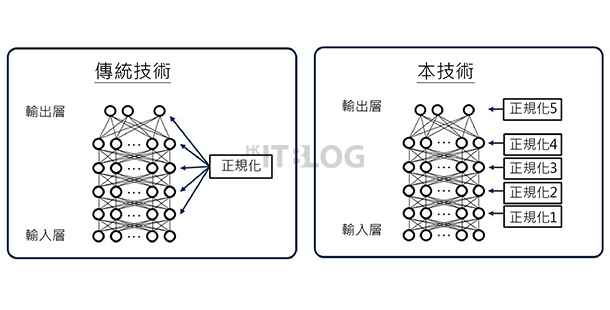

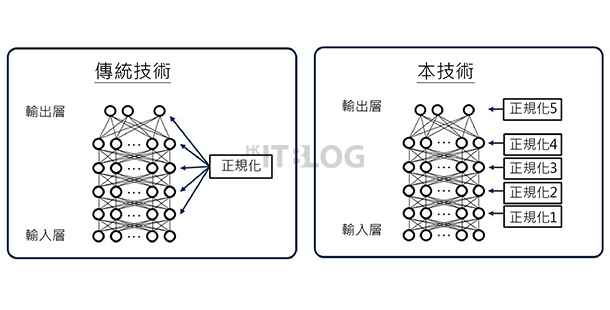

接下來到深度學習了。深度學習的原理很簡單,其實就是依照人類對生物大腦的理解而成。在大腦之中,所有神經元在一定的距離內均可連接到其他神經元,而人工的神經網絡會先將一個目標例如是影象進行抽離,例如是顏色、數字、是否移動中、高度等,抽離後的每個項目都會儲存到不同的單一神經元之中,每個單一神經元會有各自的分配權重,最終輸出的決定是綜合了所有神經元的決定而得出的。

基於這種設計,深度學習同樣地需要像人類一樣,需要參考大量的 Sample 以學懂某一樣事情!然而它會將一個物件自動抽離成多個部份,因此當該目標物件的其中一部份被遮蓋時,亦可照常辨識到該物件;再加上剛才都提過,每一個神經元都有獨立的思考模式,因此相比起 Weak AI,基於深度學習的 AI 本身將擁有更強的靈活性、更準確的判斷能力,而且更可通過不斷學習而令其判斷比人類更為準確,其中一個例子就是 Google 的 AlphaGo。

這種超強 AI 暫時仍未被應用到資安防禦範圍,現時很大程度上各家資安廠商都是以 Weak AI 的方式來開發針對指定範圍的 AI 防禦功能!未來採用深度學習的強 AI,將會製造出一種前所未見的方式以針對資安防禦,例如是一個與真人無異的機械人,以鍵盤配合上滑鼠以每秒數千次的方式檢視網絡各種活動;又或者通過採用一種 AI 封包隨時或更快一步得知可疑行為從而作出破壞,以上純粹推測,不過未來科技,甚麼都有可能;2018 年將會是 AI 以及深度學習,由研究轉向真正應用的重要一年,十分期待!

以上資訊由www.hkitblog.com提供

步伐加快!數碼工作間轉型歸功於人工智能? – HKITBLOG

步伐加快!數碼工作間轉型歸功於人工智能?

傳統企業的工作模式大多要求員工到辦公室上班工作,但隨著科技日益進步,數碼轉型為企業帶來巨大的好處,導致傳統工作模式面臨重大挑戰;而近日一項調查更進一步證實數碼轉型為企業帶來的轉機。

達科 (Dimension Data) 近日的研究顯示,來自五大洲十五個國家的八百家受訪企業當中,有四成同意獲得競爭優勢和改善業務流程是其數碼轉型策略的首要目標。有 62% 的受訪者期望,未來兩年內數碼轉型技術能為企業引入諸如虛擬顧問等科技。此外,有 58% 的受訪者更期待公司在未來兩年開始積極投資於支援虛擬顧問的技術。

如今,數碼工作間不再只涵蓋主管及下屬;互相協作以共同完成項目的同事;又或與客戶和合作夥伴進行互動的員工。愈來愈多的「虛擬僱員」已進駐工作間,它們雖然沒有實體形態,但對企業營運發揮著重要的作用。

儘管人工智能 (AI) 技術仍處於初期階段,目前的技術水平已足以讓其在企業擔任虛擬助理的角色,而且亦能在某些行業大顯身手,例如在銀行充當虛擬櫃台服務員和虛擬顧問。虛擬助理以機器人的形式嵌入特定的應用,能夠透過人工智能引擎和機器學習技術來回答一些基本問題。

但是報告指出,僅僅採用以上技術並不足夠。企業已日益利用分析工具來了解這些技術對其業績的影響。有 64% 的受訪者使用分析工具來改善客戶服務,58% 的受訪者就利用分析工具進行工作間技術基準比較。

與此同時,約 30% 的企業表示,他們很早之前就實施數碼轉型計劃,並已開始獲益,而其他企業則仍處於計劃制定初期階段。

不過,企業文化往往是其中一個妨礙機構實施數碼工作間的因素。科技與企業文化通常都會對工作模式改變造成障礙而非幫助。然而,成功採取新工作方式的最大障礙來自於 IT 問題,且受訪者認為另一大障礙源於組織問題。對於採用新協作和生產力工具以支援靈活工作模式而言,現有 IT 基建架構的複雜程度將成為一個主要障礙。唯有 IT 部門與業務單位負責人緊密合作,企業方能成功轉型。

企業也逐漸運用新的工作間技術來駕馭需求不斷增加的客戶服務。其中便有 45% 的受訪企業表示,他們因使用數碼工作間技術而提升了客戶滿意度。

以上資訊由www.hkitblog.com提供

全面智能化!環法單車賽將首次引入機器學習技術 – HKITBLOG

全面智能化!環法單車賽將首次引入機器學習技術

一年一度的環法單車賽將於 7 月 1 日至 23 日舉行。主辦機構阿莫里體育組織 (Amaury Sport Organisation,簡稱 A.S.O.) 與賽事官方技術合作夥伴達科 (Dimension Data) 於 6 月 29 日聯合宣布,今屆環法單車賽將首次引入機器學習技術,為全球的單車愛好者帶來前所未有的體驗。

由達科與 A.S.O. 共同開發的達科數據分析平台今年將引入機器學習技術和精密的演算法,把賽事即時數據與過往賽事的數據結合,並因應賽事進展提供更深入的分析。各選手的愛好者可利用車手的檔案了解個別車手的專項賽道和比賽情況。

安裝於每部單車座位下的全球衛星定位系統訊號轉發器是即時追蹤和數據分析解決方案的核心。轉發器收集的數據會結合賽道斜度及天氣情況等外部數據,得出個別車手的實時速度與所在地點、各個車手之間的距離,以及參賽隊伍陣容等種種分析結果;而另一特點是在 21 個賽段所產生並分析的數據點由去年的 1 億 2 千 8 百萬個激增至本年的 30 億個。

此外有關方面更首度利用預測性分析技術,預測發生不同賽事狀況的可能性,例如主車群會否在某賽段趕上突圍車手。

另一方面,今年的環法單車賽亦利用了一個完全基於雲端的虛擬化數據中心提供所需的運作規模,因而可減省在賽事現場負責操作系統的人手。由於雲端可在世界不同地方進行管理,所以這種方案模式同時提供了地理上的靈活性。

環法單車賽部分重點資料包括:

– 22 支隊伍的 198 位選手將於全長 3,540 公里的賽道產生超過 1 億 5000 萬個有關地理空間和環境的讀取值數據

– 環法單車賽的即時追蹤網站 racecenter.letour.fr 在 2016 年平均每秒處理 2,000 頁要求,而今年己經提升效能至支持每秒 25,000 頁要求

– 2016 年全球有來自 190 個國家的 100 個電視頻道播放了共 6,100 小時的節目。今年電視廣播的時數將由去年的 80 小時增加至今年的 105 小時,且賽事將由每個賽段的首公里便開始廣播

以上資訊由www.hkitblog.com提供